要搞明白IO相关的概念,首先就得弄清楚同步与异步,阻塞与非阻塞到底是什么意思。

同步与异步

想要搞明白IO模型,就先得搞明白“同步”与“异步”的关系。

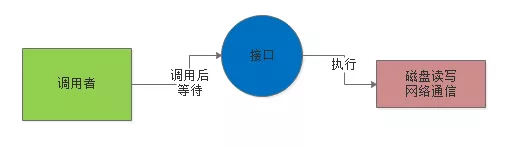

所谓的“同步”,比如说调用者去调用一个接口,这个接口比如要执行一些磁盘文件读写操作,或者是网络通信操作。

假设是“同步”的模式,调用者必须要等待这个接口的磁盘读写或者网络通信的操作执行完毕了,调用者才能返回,这就是“同步”,如下图所示:

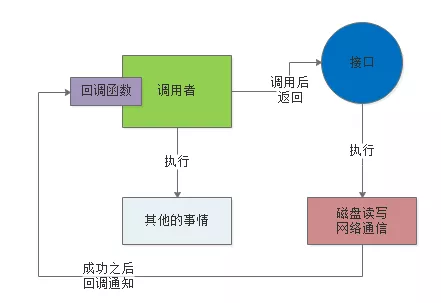

所谓的“异步”,就是说这个调用者调用接口之后,直接就返回了,他去干别的事儿了,也不管那个接口的磁盘读写或者是网络通信是否成功。

然后这个接口后续如果干完了自己的任务,比如写完了文件或者是什么的,会反过来通知调用者,之前你的那个调用成功了。可以通过一些内部通信机制来通知,也可以通过回调函数来通知,如下图。

用生活中的例子理解同步与异步

如果给大家举个生活中的例子,那么就可以用买烟这个事儿来举个例子

比如说现在你要去一个柜台买很多条香烟,但是现在柜台没那么多货,他需要打电话给库房来查一下有没有足够的货。

这个时候,库房的工作人员正好去吃饭了,那现在你有两种选择:

第一种选择,你可以在柜台等着,一直等待库房工作人员回来,柜台专员打通电话给他查到了库存是否充足,你再走。

这个就是“同步”,你找柜台工作人员买香烟,他要打电话给库房工作人员问库存,如果你选择“同步”模式,那么你就在柜台一直等着,直到成功查询到库存为止。

第二种选择,你可以先回家干点儿别的,比如说洗衣服做饭之类的,然后过了一会儿,柜台工作人员打通电话给库房工作人员,查到香烟库存了,就会打个电话给你,告诉你这个事儿。

这就是“异步”,你跟柜台工作人员说了这个事儿,就直接走了,干别的去了,柜台工作人员后面完成他的任务之后,就会反过来打电话回调通知你。

阻塞与非阻塞

实际上阻塞与非阻塞的概念,通常是针对底层的IO操作来说的。

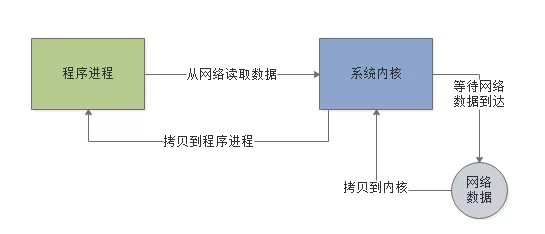

比如现在我们的程序想要通过网络读取数据,如果是阻塞IO模式,一旦发起请求到操作系统内核去从网络中读取数据,就会阻塞在那里,必须要等待网络中的数据到达了之后,才能从网络读取数据到内核,再从内核返回给程序,如下图。

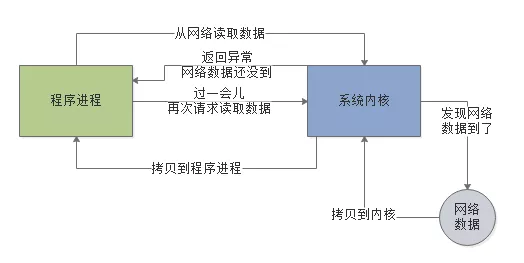

而非阻塞,指的就是程序发送请求给内核要从网络读取数据,但是此时网络中的数据还没到,此时不会阻塞住,内核会返回一个异常消息给程序。

程序就可以干点儿别的,然后过一会儿再来发起一次请求给内核,让内核尝试从网络读取数据。

因为如果网络中的数据还没到位,是不会阻塞住程序的,需要程序自己不断的轮询内核去尝试读取数据,所以这种IO就是非阻塞的。如下图:

不要把“同步/异步”概念和“阻塞/非阻塞”概念混淆起来,实际上他们是两组不同的概念。

“同步/异步”更多的是针对比如接口调用,服务调用,API类库调用,类似这样的场景。

而“阻塞/非阻塞”概念针对的是底层IO操作的场景,比如磁盘IO,网络IO。但是在Java IO模型里,两种概念之间是有一定的关联关系的 。

Unix支持的5种IO模型

Unix操作系统支持的IO模型主要就是5种:

- 阻塞IO:就是上面图里的那种阻塞IO模式,程序发起请求之后会阻塞,一直到系统内核发现网络中有数据到达了,拷贝数据给程序进程了,才能返回

- 非阻塞IO:就是上面图里的那种非阻塞IO模式,程序发起请求读取数据,系统内核发现网络数据还没到,就返回一个异常信息,程序不会阻塞在IO操作上,但是过一会儿还得再来发起请求给内核,直到内核发现网络数据到达了,此时就会拷贝数据给程序进程

- IO多路复用:这个下面来讲

- 信号驱动式IO:一般很少用到,这里不说明

- 异步IO:下面来讲

JDK 1.4之前的同步阻塞IO

在JDK 1.4之前,主要就是同步阻塞IO模型,在Java里叫做BIO。

在Java代码里调用IO相关接口,发起IO操作之后,Java程序就会同步等待,这个同步指的是Java程序调用IO API接口的层面而言。

而IO API在底层的IO操作是基于阻塞IO来的,向操作系统内核发起IO请求,系统内核会等待数据就位之后,才会执行IO操作,执行完毕了才会返回。

JDK 1.4之后的同步非阻塞NIO

在JDK 1.4之后提供了NIO,他的概念是同步非阻塞,也就是说如果你调用NIO接口去执行IO操作,其实还是同步等待的,但是在底层的IO操作上 ,会对系统内核发起非阻塞IO请求,以非阻塞的形式来执行IO。

也就是说,如果底层数据没到位,那么内核返回异常信息,不会阻塞住,但是NIO接口内部会采用非阻塞方式过一会儿再次调用内核发起IO请求,直到成功为止。

但是之所以说是同步非阻塞,这里的“同步”指的就是因为在你的Java代码调用NIO接口层面是同步的,你还是要同步等待底层IO操作真正完成了才可以返回,只不过在执行底层IO的时候采用了非阻塞的方式来执行罢了。