建立索引的优点:

1、大大加快数据的检索速度;

2、创建唯一性索引,保证数据库表中每一行数据的唯一性;

3、加速表和表之间的连接;

4、在使用分组和排序子句进行数据检索时,可以显著减少查询中分组和排序的时间。

索引的种类

1、按照索引列值的唯一性,索引可分为唯一索引和非唯一索引;

非唯一索引:

create index 索引名 on 表名(列名) tablespace 表空间名;

唯一索引:

建立主键或者唯一约束时会自动在对应的列上建立唯一索引;

注:创建主键时,默认在主键上创建了唯一索引,因此不能再在主键上创建索引。

2、索引列的个数:单列索引和复合索引;

3、按照索引列的物理组织方式。

B树索引

create index 索引名 on 表名(列名) tablespace 表空间名;

位图索引

create bitmap index 索引名 on 表名(列名) tablespace 表空间名;

反向键索引

create index 索引名 on 表名(列名) reverse tablespace 表空间名;

函数索引

create index 索引名 on 表名(函数名(列名)) tablespace 表空间名;

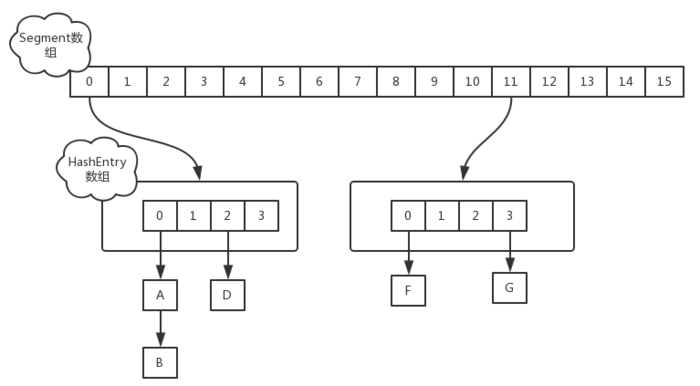

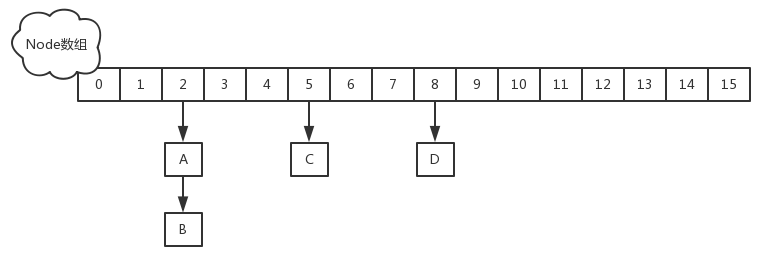

聚集索引(也叫聚簇索引)

在聚集索引中,表中行的物理顺序与键值的逻辑(索引)顺序相同.一个表只能包含一个聚集索引.如果某索引不是聚集索引,则表中行的物理顺序与键值的逻辑顺序不匹配.与非聚集索引相比,聚集索引通常提供更快的数据访问速度.

删除索引

drop index 索引名

重建索引

alter index 索引名 rebuild

索引的创建格式:

1 | CREATE UNIQUE | BITMAP INDEX <schema>.<index_name> |

UNIQUE | BITMAP:指定UNIQUE为唯一值索引,BITMAP为位图索引,省略为B-Tree索引。

<column_name> |

TABLESPACE:指定存放索引的表空间(索引和原表不在一个表空间时效率更高)

STORAGE:可进一步设置表空间的存储参数

LOGGING | NOLOGGING:是否对索引产生重做日志(对大表尽量使用NOLOGGING来减少占用空间并提高效率)

COMPUTE STATISTICS:创建新索引时收集统计信息

NOCOMPRESS | COMPRESS

NOSORT | REVERSE:NOSORT表示与表中相同的顺序创建索引,REVERSE表示相反顺序存储索引值

PARTITION | NOPARTITION:可以在分区表和未分区表上对创建的索引进行分区

使用USER_IND_COLUMNS查询某个TABLE中的相应字段索引建立情况

使用DBA_INDEXES/USER_INDEXES查询所有索引的具体设置情况。

Oracle中的索引类型

在Oracle中的索引可以分为:B树索引、位图索引、反向键索引、基于函数的索引、簇索引、全局索引、局部索引、HASH索引、降序索引等,下面逐一讲解: